Fernerkundung

Symposium "Vom Orbit zur Entscheidung: Satellitenfernerkundung in der Landesumweltverwaltung"

Erstmalig fand am 02. Oktober 2025 das Symposium "Satellitenfernerkundung in der Landesumweltverwaltung" statt. Unter dem Motto „Vom Orbit zur Entscheidung“ haben das Hessische Landesamt für Naturschutz, Umwelt und Geologie (HLNUG) und die Landesanstalt für Umwelt Baden-Württemberg (LUBW) gemeinsam mit Unterstützung von EUMETSAT in Darmstadt ein spannendes und gut besuchtes Symposium zur Satellitenfernerkundung in der Landesumweltverwaltung veranstaltet.

Das Programm und die Vorträge der Veranstaltung stehen hier zum Download bereit.

Hessen aus dem All

Aus der Ferne kann man manches besser erkennen: Riesige Wirbelstürme, die sich in den Tropen zusammenbrauen, das Ausmaß der Regenwaldabholzung im Amazonas oder das Wachstum von Megastädten. Der Einfluss des Menschen auf unseren Planeten wird aus dem All besonders deutlich. Mit beeindruckenden Bildern hat die Fernerkundung zu einem globalen Bewusstsein für Nachhaltigkeit beigetragen. Auch für regionale Fragestellungen ist die Fernerkundung heute zu einem wichtigen Werkzeug geworden – so auch für uns in Hessen.

Fernerkundung bedeutet, dass Informationen kontaktfrei erfasst werden. Mit der Fernerkundung messen wir die Eigenschaften von Objekten aus der Ferne mit unterschiedlichen Sensoren. Diese können auf Satelliten, Flugzeugen oder Drohnen befestigt sein. Historisch hat man zunächst Bilder aus der Luft – aus Ballons und Zeppelinen oder sogar mit Tauben - aufgenommen und interpretiert. Heute kennt man Luftbilder als Hintergrundkarten in Google Maps oder OpenStreetMap. Und in der Meteorologie wird schon seit den 1960er Jahren mit Satellitendaten gearbeitet.

Als Querschnittstechnologie kann die Fernerkundung Fachthemen des HLNUG unterstützen. Wir analysieren, welche Informationen aus Fernerkundungsdaten abgeleitet werden können:

Verschiedene Satelliten umkreisen die Erde, ihre Sensoren scannen regelmäßig die Erdoberfläche und deren Veränderungen im Laufe der Zeit. Viele Daten sind frei verfügbar und ermöglichen einen kostengünstigen Einsatz. Dazu trägt auch das Copernicus-Programm der Europäischen Union und der Europäischen Raumfahrtagentur ESA bei. Im Fokus von Copernicus steht die Flotte der Sentinel-Satelliten („Sentinel“ heißt Wächter), jeder Satellit hat dabei seine eigene Mission: Sentinel-1 überwacht zum Beispiel Bodenbewegungen oder macht Überflutungen besonders deutlich. Mit Sentinel-2 lässt sich Vegetation sehr gut erkennen und so lassen sich zum Beispiel die Auswirkungen von Dürren kartieren oder die Zusammensetzung von Biotopen. Die Fernerkundung liefert Informationen über den Zustand der Atmosphäre, der bebauten Infrastruktur, der Fließgewässer und Seen, des Bodens, der Wälder und anderer Ökosysteme, aber auch über die Schneebedeckung.

Durch die großen Datenmengen (Big Data) ergeben sich auch technische Herausforderungen: Beispielsweise müssen Konzepte entwickelt werden, wie und wo die großen Mengen an Daten gespeichert werden und wie sie effizient ausgewertet werden können, um neue Informationen zu extrahieren. Dabei helfen uns auch Methoden des Maschinellen Lernen und der Künstlichen Intelligenz, die in die bestehenden IT-Infrastruktur der GIS-Zentrale eingebunden werden.

Unsere Augen sehen Strahlung, die von der Sonne ausgesendet und an Objekten reflektiert wird. Vegetation reflektiert zum Beispiel viel grünes Licht, deshalb sehen wir gesunde Blätter in dieser Farbe, Weil wir blaues, grünes und rotes Licht sehen können, nennen wir es auch Sichtbare Strahlung oder Licht. Satelliten sind unsere Augen im All, denn auch sie zeichnen elektromagnetische Strahlung auf. Anders als unsere Augen „sehen“ Sensoren aber auch Strahlung mit anderen Wellenlängen und helfen uns dabei, Unsichtbares sichtbar zu machen.

Ein Sensor zeichnet die Strahlung auf, die von den Objekten der Erdoberfläche (z.B. Bäume, Häuser oder Wasserflächen) zurückgesendet wird. Die so gewonnenen Daten werden anschließend in Informationen umgewandelt, mit denen wir Wissen erlangen und nachhaltig handeln können.

Das elektromagnetische Spektrum steht im Mittelpunkt der Fernerkundung: Es erstreckt sich von Bereichen mit ganz kleinen Wellenlängen (Gamma- oder Röntgenstrahlen), über mittlere Wellenlängenbereiche wie das Sichtbare Licht hin zu den großen Wellenlängen wie Mikrowellen oder Radiowellen. Mit ihm können wir die Strahlung, mit der die Sensoren arbeiten, einteilen.

Gesunde Vegetation ist grün, denn sie absorbiert rotes und blaues Licht – es wird zur Photosynthese benötigt - und nur grünes Licht wird reflektiert. In der Fernerkundung sind aber auch die Bereiche des elektromagnetischen Spektrums interessant, die das menschliche Auge nicht sehen kann, so wie beispielweise das Nahe Infrarot – und hier reflektiert Vegetation besonders stark.

Die Fernerkundung macht sich zu Nutze, dass jedes Material auf der Erdoberfläche die elektromagnetische Strahlung anders reflektiert: Jede Oberfläche besitzt ihren ganz charakteristischen „Spektralen Fingerabdruck“. Boden, Vegetation und Wasser haben im elektromagnetischen Spektrum verschiedene Eigenschaften, so dass sie sich voneinander trennen lassen.

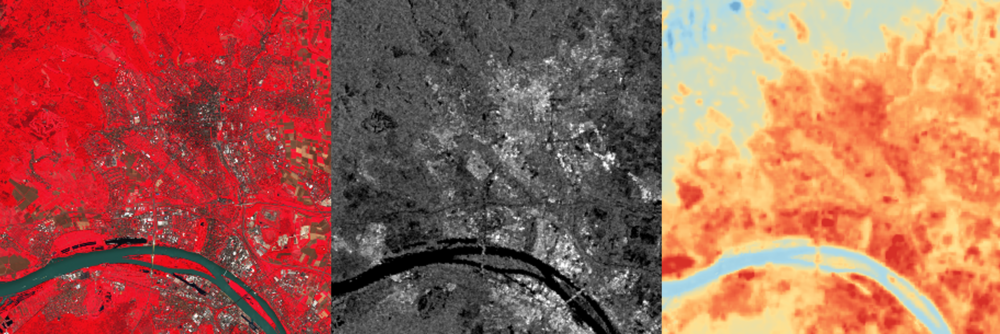

Dreimal Fernerkundung: Taunus, Wiesbaden und Rhein dargestellt mit unterschiedlichen Fernerkundungstechnologien. Von links nach rechts: Falschfarbendarstellung von Sentinel-2 (optisch), Darstellung von Sentinel-1 (RADAR) und Landoberflächentemperaturen von Landsat (thermal; blau kühler, rot wärmer)

Jede Wellenlänge erlaubt uns, unterschiedliche Eigenschaften von Objekten zu erkennen. Für eine grobe Einteilung unterscheidet man in der Fernerkundung drei Bereiche des elektromagnetischen Spektrums: optisch, thermal und RADAR.

Die optische Fernerkundung umfasst den Sichtbaren Bereich, das Nahe Infrrot und das Ferne Infrarot. Zu den optischen Satelliten gehören z.B. die beiden Sentinel-2-Satelliten des Copernicus-Programms der ESA. Die Sensoren auf Sentinel-2 scannen die Oberfläche der Erde in 13 Bereichen des elektromagnetischen Spektrums (spektrale Kanäle) und machen im Abstand von 5 Tagen Aufnahmen von Hessen. Die Erdoberfläche sieht man aber nur, wenn keine Wolken vorhanden sind. Für die Beobachtung der Landbedeckung ist Sentinel-2 besonders interessant: Die Sensoren sind wegen ihrer Kanäle im Nahen Infrarot besonders sensitiv für Vegetation. Mit ihnen kann man beispielsweise feststellen, ob die Vegetation unter Wassermangel leidet oder ob in einem See Algen wachsen. Auch wenn sich die Blätter im Herbst verfärben, verändert sich der spektrale Fingerabdruck.

Satellitendaten haben den Vorteil, dass man zu vielen Zeitpunkten große Flächen erfassen kann. Man kann aus der Vogelperspektive Strukturen erkennen und unterscheiden. Stellt man das Bild in Falschfarben dar, also nimmt man einen Spektralkanal dazu, den unsere Augen nicht sehen können, dann kann man für Vegetation noch besser Vitalitätsunterschiede erkennen.

Sentinel-2 umkreist die Erde bereits seit dem Jahr 2015. Dadurch können wir uns auch ansehen, wie sich Gebiete in Hessen über die Zeit verändern.

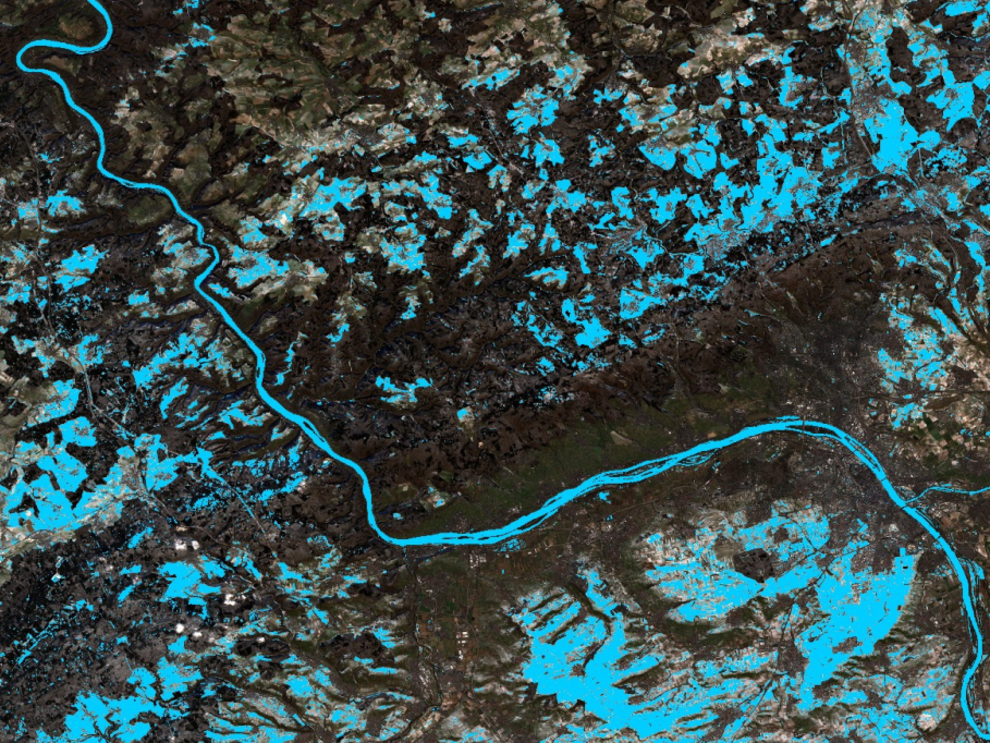

Im Gegensatz zu den optischen Sensoren, die nur Strahlung empfangen, senden RADAR-Systeme die Strahlung selbst aus. Sie empfangen dann diese Signale als Energiepulse, die je nach Oberfläche unterschiedlich stark ausfallen. Ein RADAR-Bild sieht ganz anders aus als ein optisches Bild und ist schwerer zu interpretieren, weil es nicht dem entspricht, was wir mit dem Auge sehen können. Der große Vorteil aber ist, dass RADAR unabhängig von der Wolkendecke ist und zu jeder Tages- und Nachtzeit Informationen über die Erdoberfläche aufzeichnen kann. Die Aufbereitung bedarf aber viel Übung und bringt einen hohen Aufwand in der Prozessierung der Daten mit sich. Anwendungen von RADAR sind zum Beispiel die Erfassung von Bodenbewegung oder die Erkennung von Wasserflächen und damit auch Hochwasser.

Die thermale Fernerkundung erlaubt das Messen von Temperaturen von Objekten. Das ist zum Beispiel spannend, weil man innerhalb einer Stadt im Sommer wärmere und kühlere Plätze identifizieren kann. Hier wird nicht die Temperatur der Luft gemessen, sondern die der Objekte. Diese ist oft sehr viel wärmer als die Luft.